Por Ernesto Ángeles

La última semana hemos sido testigos del furor que causó Lensa, una app que utiliza Inteligencia Artificial (IA) para crear imágenes con filtros basadas en selfies y fotos que sube el usuario (pese a que la app existe desde el 2018); sin embargo, más allá del entusiasmo que ha generado su uso, también ha presentado una serie de problemas y situaciones cuando menos incómodas para algunos usuarios, principalmente mujeres, lo que ha revivido diversos debates sobre la IA, los sesgos tecnológicos, la protección de datos personales y hasta los derechos de autor.

En este artículo tengo por intención usar el caso de Lensa como un detonante de casos e ideas para ahondar un poco en las distintas discusiones y debates que hay en torno a algunos problemas que presenta la IA, pero sin entrar en detalles técnicos o explicaciones profundas, ya que el fin último de este escrito es ilustrativo y descriptivo.

Para comenzar está el problema de la sexualización y lo que se podría considerar como prácticas machistas, misóginas y de violencia, en el caso de Lensa se presenta a través de la creación de filtros e imágenes de mujeres con poca ropa o poses sugerentes, aún cuando las fotos usadas para generar las imágenes no sean de naturaleza sexual, algo que parece es frecuente con fotos de mujeres https://www.wired.com/story/lensa-artificial-intelligence-csem/.

Es importante mencionar que el caso de Lensa no es por mucho el único, sino que existen otros muchos ejemplos de tecnologías que reflejan diversos sesgos sociales: machismo, misoginia, racismo, etc. Y es que la tecnología, específicamente aquella basada en IA, refleja sesgos ya en su estructura o funcionamiento:

Los sesgos estructurales vienen dados a partir de la construcción de la IA, ya sea por sus creadores a partir de sesgos humanos propios reflejados en el desarrollo de algoritmos y modelos, así como por la selección de datos y elementos para construir una IA o por el contexto mismo, en donde buena parte de programadores y equipos de investigación y desarrollo son hombres, blancos y angloparlantes. Por otro lado está el funcionamiento de la IA y los sesgos, ya que algunas técnicas de aprendizaje requieren la alimentación de datos en tiempo real, lo que implica el riesgo que la IA pueda aprender en el proceso a comportarse de acuerdo a los datos con los que se alimente, así como pasó en 2016 con un chatbot de Microsoft, el cual fue entrenado en Twitter, lo que implicó que en menos de un día tal programa se volviera racista, misógino y apologista del holocausto https://www.theverge.com/2016/3/24/11297050/tay-microsoft-chatbot-racist.

Entonces, ¿estamos condenados a tener IA’s con un comportamiento negativo y hasta lesivo con los derechos de algunas personas y grupos sociales? No, en realidad existen diversas estrategias para minimizar los sesgos humanos y tecnológicos: desde la sensibilización y entrenamiento de equipos de trabajo, la creación de estándares y buenas prácticas internacionales, hasta programas que revisan (y construyen) datos con los que se alimentan las IA, mucho depende de la profesionalidad, presupuesto y tamaño de la empresa, así como de qué tan apegados estén en buenas prácticas; sin embargo, poco puede hacer la tecnología para cambiar tendencias sociales existentes, sólo puede evitar amplificarlas, replicarlas y reproducirlas en su estructura y funcionamiento.

En este contexto mucho depende de en dónde se piensa usar un servicio basado en IA, ya que la existencia de sesgos puede implicar un momento incómodo, un resultado desagradable o, en el peor de los casos, implicar la segregación y exclusión social (en algunos casos extremos podría implicar la muerte, sobre todo en el área de IA en armamentos y sistemas armados autónomos, lo cual suena alejado a la realidad, pero es aún más cercano de lo que podría creerse, tal como el caso de la semana pasada en California, en donde tuvieron que dar marcha atrás a la luz verde que le habían dado a la policía de usar robots con capacidad letal https://www.theverge.com/2022/12/7/23497922/killer-robot-policy-san-francisco-reversed).

Por tanto, es importante que los tomadores de decisión y los hacedores de leyes tengan en cuenta los diferentes filtros y requisitos mínimos que deberían cumplir las IA, sobre todo aquellas con la capacidad de brindar servicios públicos o masivos, tal como las evaluadoras de crédito, los programas de reconocimiento facial o la administración pública, en donde un fallo en los sesgos de la IA puede significar que un grupo o persona vea sus derechos violados o no reconocidos.

Por otro lado está la protección de datos personales, en donde si bien la app asegura que no almacena tus imágenes, poco importa esto, ya que una vez que se alimenta la IA con la cara de un usuario, sus parámetros faciales y las imágenes creadas con ellos no se eliminan, por lo cual la app pasa a ser propietaria de los parámetros faciales y los resultados de las ediciones y los filtros (híper realistas), mismos que podría usar con fines comerciales.

Entonces, básicamente la app pasa a ser propietaria de la interpretación que hace su IA sobre los usuarios, algo bastante problemático desde diferentes aristas, como por ejemplo la seguridad digital, en donde los rasgos faciales son usados como método de autenticación.

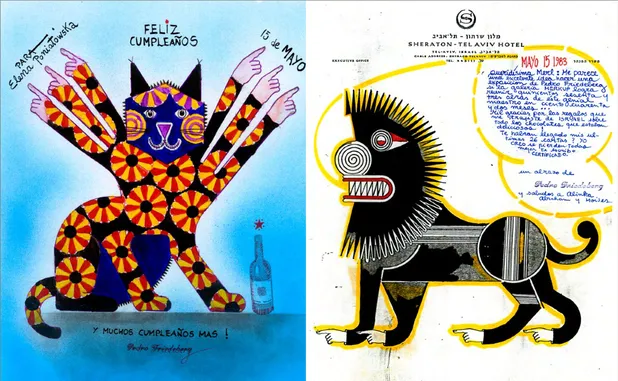

Y es justo en la parte de la creación de imágenes y retratos en donde surge otro problema asociado: la propiedad intelectual, ya que en algunos de los filtros y creaciones de la IA es posible ver la influencia de obras de arte como marco de referencia; además, está el evidente problema que la empresa dueña de Lensa pasa a ser propietaria de las creaciones de su producto: tu rostro re-imaginado.

Además, está el problema de la potencia de la IA y el uso malicioso: en caso que no exista en un futuro cercano alguna clase de límite o restricción al uso de IA tan potentes (piénse en una Lensa en 3 años), es probable que se generen y aumenten casos de suplantación de identidad y otros crímenes devenidos del uso de IA, motivo por el cual tendrán que repensarse otros métodos de identificación y autenticación, además que pone en relieve la posibilidad que los datos se conviertan en un bien más preciado aún, o mejor dicho con más posibilidades de ser explotado y vulnerado, tal como el caso de la creación de audios o imágenes de uno a partir de técnicas conocidas como Deep Fake.

Otra de las caras de este asunto es la erosión aún mayor de nociones como la verdad, autenticidad y seguridad en entornos digitales en los cuales cualquier video, foto o audio pueden no ser ciertos, sino generados a través de computadora por una IA; en donde un “ligue”, famoso o personaje político relevante pueden ser avatares digitales o contenido digital creado.

Es preocupante el uso irrestricto de estas tecnologías y no sólo por los usuarios comunes o mal intencionados, sino también por gobiernos, empresas y otros actores poderosos, los cuales pueden explotar tendencias y tensiones sociales por medio de la tecnología, borrando en el proceso nociones de verdad o la propia confianza de los usuarios hacia lo que podría esperarse que fuera considerado como verdad (que básicamente significaría la profundización de una tendencia que empeoró con el advenimiento de las tecnologías digitales).

Sin embargo, tal parece indicar que buena parte de las restricciones serán dadas por el propio mercado a través de los términos y condiciones de sus servicios, así como también a los costos y usos habilitados que se les pueda dar; a menos que la tecnología afecte a los actores poderosos (principalmente EUA), en donde cabría esperarse la exportación de la regulación tecnológica, siempre acorde a los intereses y ganancias del gran capital, claro.